Besonders kleine und besonders große Strukturen fallen auf – wie Cloud-Computing und das Internet der Dinge (engl. IoT). Die Cloud wird mittlerweile von jedem mittleren und großen Unternehmen eingesetzt, selbst privat nutzen die meisten Menschen einen Cloud-Dienst wie Dropbox, Office365 oder Google Docs, selbst wenn sie es nicht als Cloud wahrnehmen. Eine aktuelle Studie von IT-Management-Anbieter Solarwinds ergab, dass 86 Prozent der deutschen IT-Experten Cloud Computing und hybride IT unter den fünf wichtigsten Technologien in der IT-Strategie ihrer Unternehmen sehen. Während die Cloud den Hype schon hinter sich hat und im Alltag angekommen ist, gilt IoT zurzeit noch als Zukunftstechnologie. Aber dass beide Technologien – Cloud und IoT – zu immer mehr intelligenten, vernetzten Endgeräten im persönlichen und beruflichen Umfeld führen werden, steht außer Frage.

Lokal erzeugen, lokal verarbeiten

In den letzten Monaten wurde eine weitere Diskussion angestoßen: Wie werden lokal erzeugte Daten am besten verarbeitet? Die Cloud bietet unendliche Rechen- und Speicherkapazität, ist aber nur über latenzbehaftete Weitverkehrsverbindungen erreichbar. Die Kleinstcomputer in den IoT-Geräten agieren nah am Geschehen, haben jedoch limitierte CPU-Kapazität und meist keine Massenspeicher. Eine wahrscheinliche Folge sind Edge-Konzentratoren, kleine Rechenzentren, die irgendwo zwischen Cloud und IoT-Endgerät angesiedelt sind. Analyst Thomas J. Bittman von Maverick Research schätzt in seinem aktuellsten Report, dass das Verhältnis zwischen Edge-Computing und Cloud in den kommenden vier, fünf Jahren den Schwerpunkt der Datenproduktion und -verarbeitung weg von zentralen Rechenzentren hin an den „Rand“ (Edge) verlagert.

Ein plakatives Beispiel sind zukünftige Anwendungen im automobilen Umfeld. Sowohl in den Fahrzeugen selbst, als auch in der Peripherie entstehen zahlreiche Daten. Alles, was das Auto selbst für seine Funktion benötigt, wird innerhalb des Fahrzeugs bearbeitet. Andere Informationen, die auch für den Rest der Verkehrsteilnehmer interessant sind, müssen mit der Umgebung geteilt werden. So ist es sinnvoll, wenn alle Fahrzeuge auf dem gleichen Abschnitt der Autobahn erfahren, dass bei einem Auto eine Notbremsung ausgelöst wurde und es nun zum Stillstand gekommen ist. Auffahrunfälle könnten durch diese Information vermieden oder zumindest deutlich reduziert werden. Diese Information erst in die Cloud zu schicken und dann an alle relevanten Fahrzeuge zu verteilen wäre zwar möglich, aber umständlich und fehleranfällig. Was, wenn die Netzverbindung gerade nicht besteht oder überlastet ist? Oder wenn die Auslastung des zuständigen Servers zu hoch ist und seine Bearbeitungszeiten länger als sonst? Für die Fahrzeuge in unmittelbarer Nähe des gebremsten Autos geht es um Sekunden oder Sekundenbruchteile. Es ist klar, dass es in so einem Fall erheblich sinnvoller wäre, wenn der Weg in die Cloud und zurück vermieden wird und genau hier kommt Edge Computing ins Spiel.

Ein Rechenzentrum an jeder Ecke

Thomas Bittmans Hauptthese lautet, dass sich das Wachstum in der Cloud verlangsamt und Rechenleistung und Speicherkapazität an den Rand des Netzwerks verlagern. Computer und Daten rücken näher an die Benutzer. Diese kleinen Edge-Rechenzentren werden überall auftauchen, längs der Straßen, an Verkehrsknotenpunkten, an öffentlichen Plätzen oder auch in größeren Industriebetrieben, wo sehr viele Sensordaten mit extrem hohen Anforderungen an die Latenz verarbeitet werden müssen. Edge Computing kann man sich ganz abstrakt als zusätzliche virtualisierte Schicht zwischen Datenerzeuger und Cloud vorstellen. Es ist eine lokale Entscheidungs- und Verarbeitungsebene, die nachgeordnete Instanzen entlastet. Diese Schicht bereitet Daten nach vorgegebenen Regeln auf und verbessert dadurch die Antwortzeiten, reduziert den Bandbreitenbedarf für die Cloud-Verbindung und verringert die benötigte Speicherkapazität im Rechenzentrum. Damit sind Anwendungen möglich, die sich nur mit der Cloud aufgrund zu geringer Bandbreite nicht umsetzen lassen oder die Daten erzeugen, die nur vor Ort, im lokalen Kontext, eine Bedeutung haben und nicht zentral bearbeitet werden müssen. Je mehr IoT-Geräte in Zukunft die Fabrikhallen, Straßen und Gebäude besiedeln, desto wichtiger wird Edge Computing für das effiziente und kostengünstige Internet der Dinge werden.

Verfügbarkeit über alles

Rechenzentren für Edge Computing müssen eine extrem hohe Verfügbarkeit aufweisen, da sie auch sicherheitsrelevante Anwendungen mit Rechenleistung versorgen werden, wie – siehe Beispiel – im Umfeld vernetzter Fahrzeuge. Sie sind zudem meist an entfernten und nur remote überwachten Standorten zu finden, so dass Fehler nur nach verhältnismäßig langer Wartezeit behoben werden. Die darin verwendeten Systeme sollen möglichst autark agieren und dafür müssen die Umgebungsbedingungen extrem zuverlässig bereitgestellt werden. Ein weitreichender Faktor ist die Stromversorgung. Dabei geht es zunächst um die Qualität von Spannung und Frequenz. Deutschland verfügt über eine sehr stabile und saubere Stromversorgung im europäischen und vor allem im internationalen Vergleich. Trotzdem sollte man sich nicht vom sprichwörtlich unbegrenzt verfügbaren Strom aus der Steckdose täuschen lassen. Der Energieexperte Staffan Reveman weiß: „Auch wenn die Bilanz auf dem Papier gut aussieht, darf man nicht vergessen, dass Ausfälle unter drei Minuten nicht von der Statistik erfasst werden. Und durch die fortschreitenden Umbrüche im Energiemix, mit zunehmenden volatilen erneuerbaren Energieanteilen, kann im Moment niemand absehen, wie sich die Versorgungssicherheit des elektrischen Stroms entwickeln wird.“ Schon heute schwanken Netzspannung und -Frequenz ständig. Das wird nur ohne Messgeräte nicht sichtbar, weil die Netzteile mit Schwankungen innerhalb bestimmter Toleranzen umgehen können und weil unterbrechungsfreie Stromversorgungen über ihre Filter- und Überbrückungsfunktionen die Differenzen ausgleichen. Die falsch gehenden Uhren zeigten Anfang 2018, wie schnell sich schon kleine Änderungen in der Frequenz bemerkbar machen.

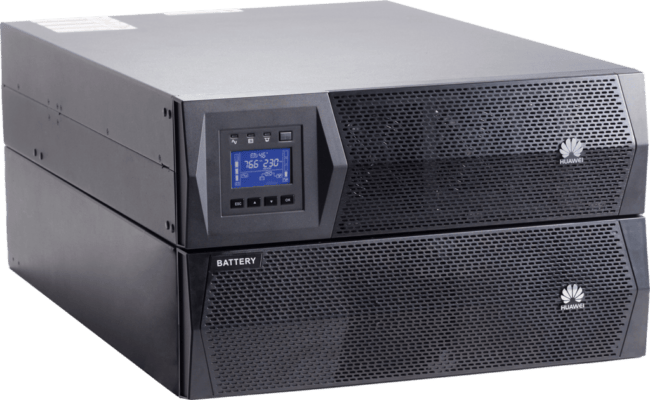

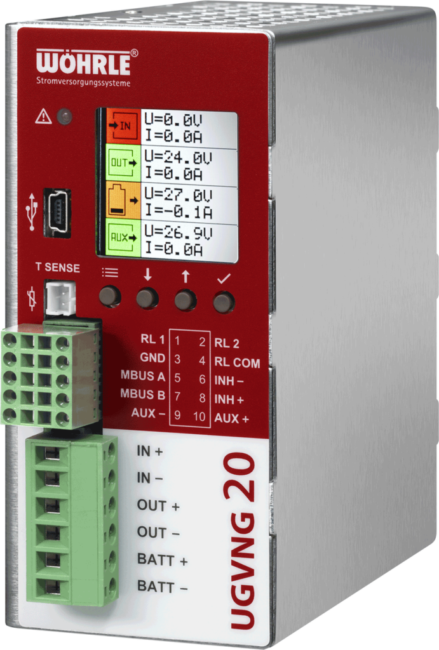

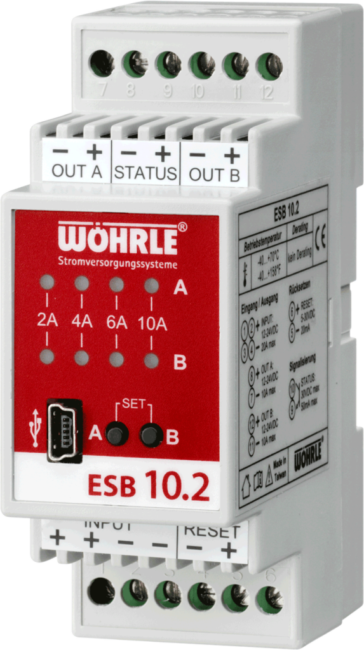

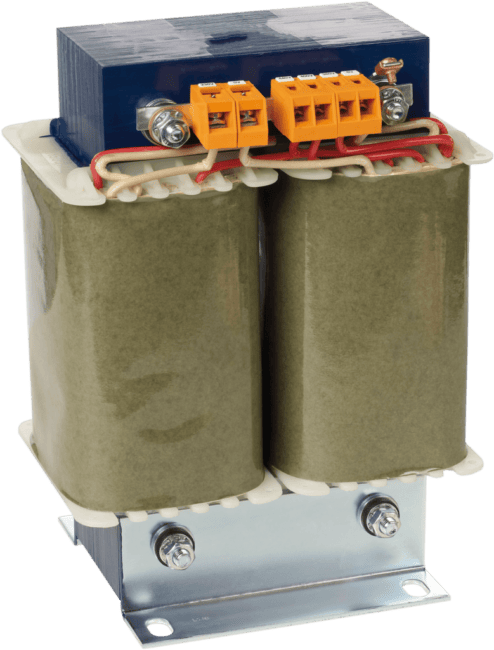

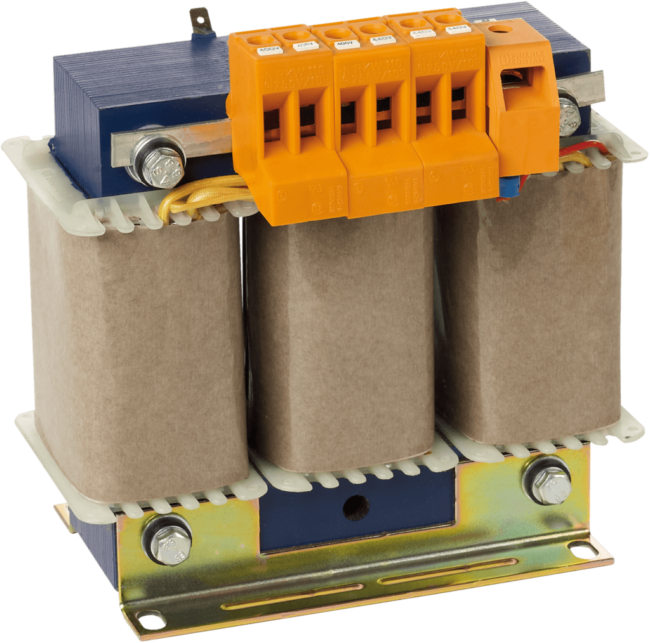

IT-Equipment ist noch viel stärker auf Spannungs- und Frequenzstabilität angewiesen. Hohe Resistenz gegen Überspannungen und Variabilität bei der Verarbeitung der Eingangsfrequenz wiegt meist schwerer als eine extrem lange Überbrückungszeit. Kurze Einbrüche fangen unterbrechungsfreie Stromversorgungen über die Kondensatoren in der DC-Strecke ab. Je größer der Schwankungsbereich sein darf, desto universeller kann die USV verbaut werden. Das gilt auch für die Frequenzregulierung. Speziell für den Einsatz in Industrieumgebungen entwickelte USV-Anlagen wie die Produkte von Wöhrle Stromversorgungssysteme, verkraften Schwankungen zwischen 40 und 70 Hertz und halten trotzdem die gewünschte Ausgangsfrequenz stabil.

Service, Reparatur und Standzeiten beachten

Gerade USVs an schwer erreichbaren Standorten müssen Akkus mit besonders langen Wartungsintervallen nutzen. Mit Reinblei-Akkus sind bis zu zehn Jahre – in der Regel gegen Aufpreis – möglich und lohnen sich, wenn man die Kosten durch aufwändige Serviceeinsätze gegenrechnet. Mittlerweile kommen auch Lithium-Ionen-Typen zum Einsatz, die eine erheblich höhere Energiedichte aufweisen. Damit sind längere Überbrückungszeiten trotz geringer Größe möglich. Li-Ion-Akkus haben auch Vorteile bei der Entgasung, die für Blei-Akkus gewährleistet sein muss. Das ist bei den oft hermetisch geschlossenen Schaltschränken in Industrie- oder Outdoor-Umgebungen nicht einfach.

Die Verfügbarkeit der unterbrechungsfreien Stromversorgung beeinflusst direkt die Funktion und Verfügbarkeit der nachgeschalteten Last. Viele Anwender glauben, dass eine möglichst hohe MTBF (Mean Time Between Failure) der wichtigste Parameter für die Verfügbarkeit einer USV ist. Doch die MTBF ist eine statistische Rechengröße, sie kann zutreffen, muss aber nicht. Für den praktischen Einsatz ist nicht relevant, wie lange es dauert, bis die USV ausfällt, sondern wie lange es dauert, bis sie wieder ohne Einschränkungen funktioniert. Dafür sind zwei weitere Faktoren entscheidend. Zum einen die Mean Time To Recover (MTTR). Sie gibt an, wie schnell eine USV instand gesetzt

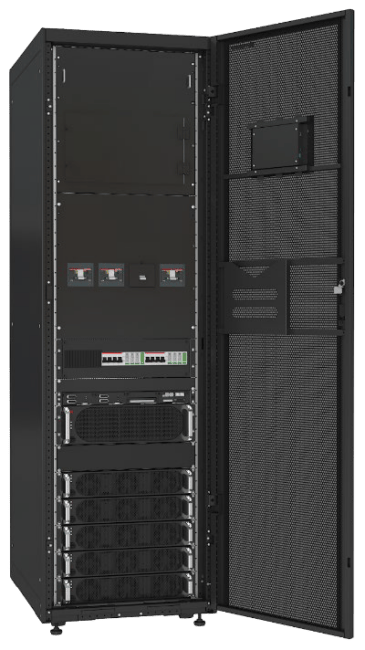

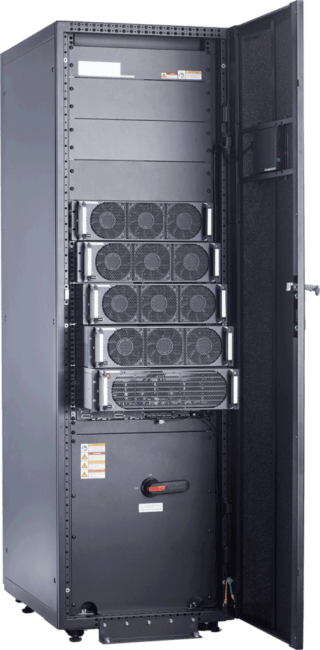

werden kann, unabhängig vom Fehler. Der zweite Faktor ist Modularität und damit Redundanz. USVs für schwierige Einsatzbedingungen müssen modular aufgebaut sein, mit Leistungsmodulen, die im laufenden Betrieb getauscht werden können (Hot-Plug). Modulbauweise erlaubt es, die Last mit n+x Konfigurationen zu betreiben. So können x Module ausfallen, ohne dass die Last auf die Versorgung durch die USV verzichten muss. Von Wöhrle Stromversorgungssysteme sind Leistungsmodule von 10 kW bis 50 kW verfügbar, um Leistungen bis in den Megawattbereich abzudecken.

Modularität erleichtert Service und Reparatur. Kaputte Leistungsmodule werden einfach, auch von ungeschulten Personen, gegen ein mitgebrachtes neues Modul getauscht – die MTTR verbessert sich dadurch dramatisch. Serviceeinsätze werden ebenfalls erleichtert. Während der Techniker ein Modul testet, übernehmen die verbleibenden Module die Absicherung, Bypass-Modus ist nicht nötig. Auch wenn die Kosten bei hohen Verfügbarkeitsanforderungen normalerweise keine Top-Priorität haben, sind niedrigere Betriebskosten besser als hohe. Die USV kann als Dauerläufer für einen nicht unerheblichen Anteil am Stromverbrauch verantwortlich sein. Je höher der Wirkungsgrad der USV ist, desto geringer fällt die Belastung für die Energiebilanz aus. Was bislang eine rein ökonomische Motivation ist, kann bald regulatorische Vorgabe sein. „Im Moment erzeugen wir Strom in Deutschland immer noch mit fast 50% fossilen Energieträgern,“ so Staffan Reveman. „Von einer wirklichen Dekarbonisierung, wie sie die Energiewende voraussetzt, sind wir noch meilenweit entfernt. Es ist anzunehmen, dass die politischen Rahmenbedingungen uns zu umfangreichen Energieeffizienzmaßnahmen zwingen werden.“ Moderne, einschubmodulare Systeme mit intelligenten Stromsparmodi können Wirkungsgrade über 95% erreichen und die Betriebskosten im Zaum halten. Weil die Auslastung normalerweise großen Einfluss auf den Wirkungsgrad hat, sind einschubmodulare Systeme ebenfalls im Vorteil. Durch die Leistungsmodule können solche USVs näher am optimalen Betriebspunkt arbeiten, als monolithische USVs.

Edge-Zeitalter steht dicht bevor

Edge-Computing wird der nächste große Trend, da ist sich Thomas Bittman sicher: „IoT und intuitive, interaktive Benutzeroberflächen werden ein Drittel der großen Unternehmen dazu bringen, bis 2021 Edge-Standorte zu bauen oder etwa in Co-Location zu nutzen.“ Damit werden auch Lösungen für langfristig autarke Mini-Rechenzentren notwendig und die wiederum benötigen zuverlässige Stromversorgungen. Einschubmodulare USV-Systeme für Industrieumgebungen sind heute schon verfügbar und passen optimal zum Anforderungsprofil von Edge-Computing. Mit solchen USVs lassen sich Kleinstrechenzentren überall langfristig und zuverlässig betreiben.